前回までは「gpt-oss-20b」を使ってテキストデータを用いたLLMの活用方法を解説してきた。テキストデータだけでも十分活用できるが、欲を言えば画像や動画、音声なども取り扱えるようにしたいところだろう。

そんな方に朗報だ。LM Studioではテキストデータだけでなく、画像も理解できる視覚言語モデル(VLM:Vision-Language Model)に対応したAIモデルを読み込むことで、さらに活用の幅を広げられる。

残念ながらgpt-oss-20bはVLM対応のモデルではないため、今回の記事ではいったんgpt-oss-20bから離れ、VLM対応のモデルをローカルPC環境で使う方法を確認していこう。

●LM StudioでVLMを試す

|

|

|

|

それでは早速、前回までに紹介してきたLM Studioを使ってVLMを試してみよう。まずは、LM Studioの左側にある虫眼鏡アイコンをクリックし、モデルのダウンロード画面に移動する。

モデルのダウンロード画面が表示されるので、モデル名の検索欄に「gemma」と入力し、Geminiモデルの開発に用いられた研究と技術に基づいてGoogleが作成した「gemma-3-12b」をダウンロードしよう。これは画像データも扱えるモデルだ。

モデルのダウンロードが完了すると、「Downloads」ウィンドウに「モデルを読み込む」ボタンが表示されるので、クリックしてgemma-3-12bを読み込もう。

前回、ユーザーインタフェースの複雑さをパワーユーザーモードに切り替えていたので、モデル読み込み時のパラメーター入力画面が表示されるはずだ。

今回はテストで利用するため、コンテキスト長はデフォルト設定のまま、「モデルを読み込む」ボタンをクリックする。

|

|

|

|

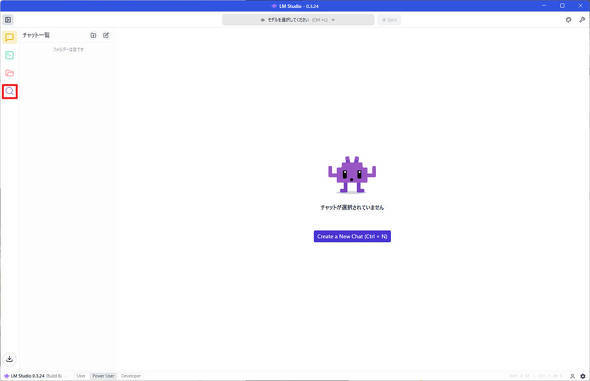

モデルの読み込みが完了したら、「Create a New Chat」ボタンをクリックし、新規のチャットインタフェースを開こう。

ここまで完了したら準備は完了だ。早速、gemma-3-12bを使って画像認識機能をいろいろと試してみよう。

●gemma-3-12bで画像認識機能を試す

gemma-3-12bは添付された写真の内容を認識し、入力されたプロンプトを元に処理が可能なモデルだ。LM Studioと組み合わせることで、初心者でも簡単に画像データを使ったLLMの利用が実現できる優れものだ。

gpt-oss-20bと比べてパラメーター数が少ないため、より高速なテキスト生成が期待できるが、iPhoneで撮影した画像を読み込んでから、処理するまでの時間がどれほどかかるか気になるので、実際に筆者が撮影した写真を用いて試してみた。これが参考になれば幸いだ。

|

|

|

|

●撮影した写真に何が写っているか聞いてみた

それでは早速、gemma-3-12bを読み込んだLM Studioに、筆者が先日に土合駅(群馬県みなかみ町)で撮影してきた写真を添付し、「この写真は日本で撮影されたのですが、何が写っているか教えてください」というプロンプトを実行してみた。

gemma-3-12bを読み込んだ状態のLM Studioを見てみると、gpt-oss-20bを読み込んだ際に表示されなかった写真アイコンが表示されているので、こちらをクリックしよう。

するとプロンプト入力欄に画像のサムネイルが表示される。添付した画像について何を聞きたいのか、プロンプト入力欄に入力して「↑」アイコンをクリックし、プロンプトを実行しよう。

なお、例では「この写真は日本で撮影されたのですが、何が写っているか教えてください」と入力している。

プロンプトを実行すると、下記の通り回答が生成される。少ししか写っていないレールもしっかりと認識している。さらにホームの背景の自然を認識した上で「日本のローカル線の駅のホーム」と回答が得られた。

この写真は日本のローカル線の駅のホームです。

特徴としては、以下のような点が挙げられます。

・線路とホーム:線路の横に黄色い点字ブロックが設置されているのが見えます。

・架線柱:電車を動かすための架線を取り付ける柱があります。

・自然豊かな風景:ホームの背景には緑豊かな山々が広がっており、日本の地方にある駅であることが分かります。

これらの要素から、この写真は日本で撮影されたローカル線の駅のホームであると判断できます。

なおiPhoneで写真を撮影すると、初期設定ではJPG形式ではなく圧縮率の高いHEIC形式で保存される。

今回はHEIC形式のままLM Studioに添付した場合と、PCでJPGに変換した場合とで、それぞれ回答が生成されるまでの時間を測定してみた。結果は以下の通りだ。

HEIC形式のままでもLM Studioで取り扱えるが、ファイルを開くまでにかなりの時間を要する。もし利用するのであれば事前にJPG形式にPCで変換しておく方が無難だろう。

●料理を正常に認識できるかチェック

続いて、筆者が外食した際に撮影した写真をLM Studioに添付し、gemma-3-12bで正常に認識できるか試してみた。

まずは、近所にある鶏白湯ラーメンを撮影した写真を試してみた。この鶏白湯ラーメンは、泡立ったスープと豊富なトッピングも相まって、麺が見えない状態だ。この状態でラーメンと認識できるのだろうか……?

今回使用したプロンプトでは「この写真には何が写っていますか?」と、プロンプトから一切情報を与えずに回答を生成したところ、下記の通りgemma-3-12bはこの写真の料理を「つけ麺」と認識していることが分かる。

この写真には、つけ麺が写っています。

特に、以下の特徴が見られます。

・白いスープ:クリーミーな白色のスープは、おそらく乳化系のつけ麺です。

・チャーシュー:薄切りになったピンク色のチャーシューが添えられています。

・薬味:ネギや芽葱、トマトなどの薬味が乗っています。

・どんぶりの縁:どんぶりの縁には「もりひろ」という文字が見えます。これはつけ麺店「もりひろ」のようです。

全体的に見て、乳化系のつけ麺で、お店の名前は「もりひろ」であることが分かります。

ラーメンとは認識しなかったが、スープの色やトッピングから麺が写っていないにもかかわらず、「これはつけ麺である」と近しい回答を生成できた点は驚きだ。

ただ、丼にかかれた「もりけん」という文字を正常に認識できず、「もりひろ」と回答している。おそらく平仮名かつ、認識できた文字から回答を推論して生成したのではないだろうか。

●文字認識の精度はどの程度か?駅の看板を元にテストしてみた

さて、先ほどのラーメンの丼にかかれた文字を、gemma-3-12bは正しく認識できなかった。人であれば難なく読めるものの、筆文字ライクなデザインなので、生成AIモデルでは認識しづらいのかもしれない。

であれば、文書として記載された文字列であれば正しく認識できるはずだ。そこで筆者が先日、汗だくになりながらたどり着いた土合駅の地下ホームに設置されている看板の写真でテストしてみることにした。

駅のキャッチコピーである「日本一のモグラ駅」にある漢数字の「一」を記号として捉えてしまったが、看板の内容を認識した上で、端的に特徴を捉えていることが分かる。

この写真から読み取れる駅の特徴は以下の通りです。

・「ようこそ『日本のモグラ駅』へ」という看板がある:このことから、この駅は地下深くにある、あるいは特徴的な地形に掘られた駅であることが分かります。

・距離と時間の詳細な表示:看板には、階段を上るまでの距離(338メートル、462段)や、次の出口までの距離(143メートル、24段)、下りホームの標高(583メートル)など、非常に詳細な情報が記載されています。これは、駅の位置が特殊で、利用者に注意を促す必要があることを示唆しています。

・「足元にご注意」という注意書き:地下深くにあるため、足元が暗く、滑りやすいなどの危険があると考えられます。

・看板の設置場所:看板は階段の入り口付近に設置されており、利用者が階段を上る前に情報を確認できるように工夫されています。

これらの特徴から、この駅は地下深く、あるいは山間部など特殊な地形にあるローカル線駅である可能性が高いです。また、そのユニークさから「日本のモグラ駅」という愛称で呼ばれているようです。

写真に写った文字列をしっかりと認識しているので、例えば写真撮影が許可されているセミナーで、発表スライドの写真だけ撮影しておき、後でgemma-3-12bを使えばスライド資料の文字起こしに活用できそうだ。

手書きのメモも写真で撮影すればそのままサクッと文字起こしできそうだ。ただ、筆者のように字が汚い場合は、認識率が下がってしまうかもしれないが……。

●画像に対応したモデルでさらに活用の幅を広げてみては

撮影した写真を外部のクラウドサービスに送信することなく、手元のPC上で処理できるため、データの外部漏えいを気にせずに、画像データを使ったLLMの利用ができる点は非常にうれしいポイントだ。

テキストデータだけでも活用幅は十分に広かったが、gemma-3-12bなどのように画像に対応したモデルを利用する事でさらに活用の幅を広げられそうだ。テキストデータだけでは物足りないと感じる方は、ぜひ試してみて欲しい。

|

|

|

|

|

|

|

|

Copyright(C) 2025 ITmedia Inc. All rights reserved. 記事・写真の無断転載を禁じます。

掲載情報の著作権は提供元企業に帰属します。

IT・インターネット

アクセス数ランキング

- 1

10月1日から開始「NHK ONE」概要(写真:ORICON NEWS)41

話題数ランキング

- 1

10月1日から開始「NHK ONE」概要(写真:ORICON NEWS)41