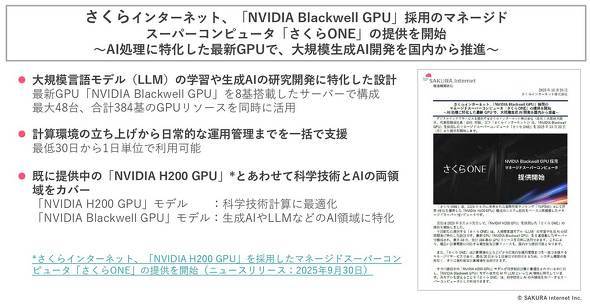

さくらインターネットが、NVIDIAのBlackwell GPUを採用したマネージドスーパーコンピュータ「さくらONE」を10月20日から提供開始した。AI処理に特化した最新GPU「NVIDIA B200 GPU」を搭載したスパコンを国内に設置することで、国内における大規模言語モデル(LLM)や、生成AIの研究、開発を推進できるという。

●NVIDIA H200 GPUモデルに加えBlackwell GPUモデルを併せて提供

さくらインターネット AI事業推進室/さくらインターネット研究所 上級研究員の小西史一さんは、「求められる計算力を持つインフラを日本国内に整備し、誰もが高い付加価値を作ることができる社会を提供することを目指す。さくらONEは、それを実現することができる。新たなサービスは、大規模言語モデル(LLM)の学習や生成AIの研究開発に特化した設計であり、継続事前学習や強化学習に適している。産業競争力強化にも貢献できると考えている。日本におけるスパコン市場をリードしていきたい」と述べた。

AI開発や先端研究には、極めて高い演算能力をもつ計算インフラが必要だが、このような環境は、これまで一部の機関に限定されていた。Blackwell GPUを採用したさくらONEを商用環境で提供することで、より多くの企業や大学、研究機関が先進的なAIを開発できる社会を実現することができるという。

|

|

|

|

さくらインターネットでは、1999年にデータセンターを開設したのに続き、2011年に石狩データセンターを開設。2016年から、機械学習を行うために、高性能GPUを利用した「高火力リソースサービス」の提供を開始している。

2023年度からは、第一次整備計画として約130億円の総事業費によって、NVIDIA H100 GPU(Hopper アーキテクチャ)を2000基以上採用した2.0EFLOPSのクラウドインフラ環境を整備し、生成AI向けクラウドサービスを提供したことで、2025年6月に発表された国際性能ランキングの「TOP500」では、世界49位を獲得した実績を持つ。

2024年度の内閣府戦略的イノベーションプログラム(SIP)第3期課題の「総合型ヘルスケアシステムの構築」においても、このインフラが活用された。

また、第二次整備計画として2027年度までに合計で1000億円の事業費を計上し、NVIDIA B200 GPU(Blackwellアーキテクチャ)を始めとしたGPUを8000基以上採用し、第1期整備と合わせて1万基のGPUを採用する。総計算能力で18.9TFLOPSを目指しているところだ。

さくらONEは、2025年9月から「NVIDIA H200 GPU」(Hopper アーキテクチャ)を8基搭載したサーバを55台、合計440基のGPUを採用したサービスを提供してきたが、今回は新たに最新GPUのNVIDIA Blackwell GPUを8基搭載したサーバを最大48台、合計384基のGPUリソースを同時に活用できるようにした。

|

|

|

|

「H200とB200の2種類のノードで構成され、GPUを使い分けられる。また、H200 GPUは1基につき700W、B200 GPUは1基につき1000Wのフルパワー電力で利用できる」とした。

NVIDIA H200 GPUモデルでは、CFDや医療/防災などの科学技術計算分野に適しており、NVIDIA Blackwell GPUモデルでは、生成AIやLLM学習などに適しているという。

「創薬研究やゲノム解析などの医薬品開発およびバイオインフォマティクスなどの他、大規模モデル学習やロボティクス、AIエージェントなどに活用できる。科学技術とAIの両領域をカバーするスパコンである」としており、気候科学や気象予測、自動車や航空宇宙(CAE)、次世代バッテリー材料、エネルギー分野、金融サービス/リスク解析、地球科学などの利用も想定している。

また、さくらONEは計算環境の立ち上げから日常的な運用管理までを一括で支援。インターネットを経由し、アクセス管理ノードを通じて、インタラクテイブノードにアクセスし、H200およびBlackwellの環境を利用でき、性能によって使い分けた利用も可能だ。

具体的なユースケースとして、LLMの開発において90日間に渡って10ノードのH200を使用して、合成データを作成する。60日間を経過した時点で20ノードのB200の並行使用を開始し、継続事前学習を実施するなど、1つのシステムの中で異なるGPUを利用するといった使い方ができるとした。

|

|

|

|

さくらONEは、最低30日から1日単位で利用できるという。共有ストレージシステムや専有ストレージシステムに加え可搬ストレージの使用も可能であり、利用者の使い勝手を高めている。

●次の「TOP500」へのエントリーを予定 ランキング上位を目指す

現在、さくらインターネットでは、マネージドスーパーコンピュータの「さくらONE」の他、GPU用に作成されたDockerコンテナを実行できるコンテナ型GPUクラウドサービスの「高火力DOK(ドック)」、1基のGPUをVMから利用できるVM型GPUクラウドサービス「高火力VRT(バート)」、1ボディーに8基搭載されたNVIDIA TensorコアGPUを占有できるGPUベアメタルサーバ「高火力PHY(ファイ)」を提供している。

「魚屋に例えれば、高火力PHYはブリを丸ごと一匹で売っているもので、自分で魚をおろして、それだけの量をさばけるのならば、お得である。だが、自分で魚をおろせない人に切り身として販売しているのが、高火力DOKや高火力VRTとなる。これに対して、さくらONEは、予約利用型の高火力PHYで構成された高性能HPCクラスタであり、GPU8基から約400基までの環境で、高速ストレージやインターコネクトで利用でき、正常な状態で稼働していることも監視している。料亭でブリを食べやすい状態で提供しているようなものだ」と表現した。

また、さくらインターネット AI事業推進室AI基盤事業統括の須藤武文さんは、「さくらインターネットは、大規模学習領域ではGPUの調達/提供において先手を打ち、市場での存在感を拡大してきたが、想定より早く推論ニーズが拡大し、学習ニーズと推論ニーズの両方に対応する必要が出てきた。生成AIの活用フェーズが本格化し、国産プラットフォームへの期待が高まっている。2025年8月にAI事業推進室を新設し、ニーズに対して迅速に対応できる体制を整えた。準備してきた多様な生成AI向けサービスを早期に市場投入しているところであり、日本国内に向けて、国内から安価にサービスを提供できる環境を整えている」と述べた。

さらに、さくらインターネットの小西さんは、「スパコンは単に『すごく速いコンピュータ』ではなく、社会のあらゆる分野を支える『計算のインフラ』である。医療では、薬剤化合物の分子シミュレーションやゲノム解析による遺伝子診断に使用され、防災では台風の進路予想や地震のシミュレーションなど、命に関わる部分に使用されている。最近では、AI開発にも利用されている。スパコンは社会を安全にして産業を強くし、未来を作るための国家的インフラである」と定義した。

「スパコンの実現には、ハードウェアからソフトウェア、ネットワーク、電力や冷却、運用までの幅広い知識と経験が必要である。総合格闘技のような戦い方が必要だ」とし、「さくらインターネットでは、TOP500で世界49位を獲得しているだけでなく、HPCの数値演算アプリケーションでの評価では世界43位、AI関連アプリケーションの評価では世界12位、I/Oストレージ性能の総合評価は世界9位であり、さまざまな分野で使われるスパコンを構築し、これらの実績が、さくらONEにつながっている」とした。

さくらインターネットでは、2025年11月に開催される「TOP500」へのエントリーを予定しており、性能向上に向けた取り組みを継続することで、ランキング上位を目指すという。

|

|

|

|

|

|

|

|

Copyright(C) 2025 ITmedia Inc. All rights reserved. 記事・写真の無断転載を禁じます。

掲載情報の著作権は提供元企業に帰属します。

IT・インターネット

アクセス数ランキング

- 1

「眠りを変える指輪」が人気(写真:ITmedia ビジネスオンライン)67

話題数ランキング

- 1

「眠りを変える指輪」が人気(写真:ITmedia ビジネスオンライン)67