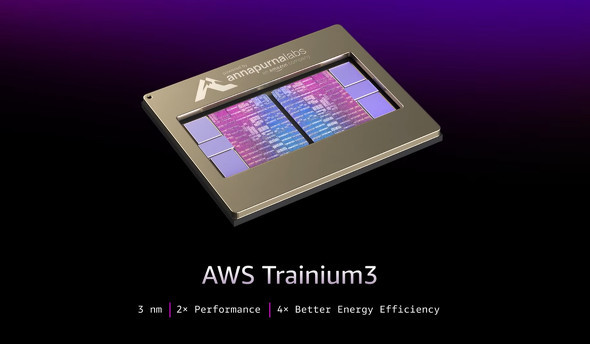

米Amazon傘下のAWSは12月3日(現地時間)、年次イベント「re:Invent 2025」で、3ナノメートルプロセスで構築した「Trainium3」チップと、自社開発のネットワーク技術を搭載したシステム「Trainium3 UltraServer」を発表した。

AWS初の3ナノメートルプロセスを採用したTrainium3チップは、前世代のTrainium2と比較して処理性能が2倍に向上。このチップを最大144個搭載可能なTrainium3 UltraServerは、システム全体として先代のTrainium2 UltraServerと比較し、演算性能が最大4.4倍、メモリ帯域幅が約4倍に強化されたほか、エネルギー効率も4倍向上した。また、新たなネットワーク技術である「NeuronSwitch-v1」の導入により、サーバ内の帯域幅が2倍になり、チップ間の通信遅延は10マイクロ秒未満に短縮されている。

AWSは、次世代チップ「Trainium4」の開発計画についても言及した。FP4演算性能で少なくとも6倍、FP8で3倍、メモリ帯域幅で4倍の性能向上を見込んでいる。米NVIDIAの「NVLink Fusion」インターコネクト技術をサポートするよう設計されており、これによりTrainium4、Gravitonプロセッサ、Elastic Fabric Adapter(EFA)が共通のMGXラック内でシームレスに連携可能になる。その結果、GPUサーバとTrainiumサーバが混在する環境でも、費用対効果の高いラック規模のAIインフラを構築できるようになるという。

Trainium3 UltraServerは、同日から一般提供を開始する。既に同製品を利用している、または導入による成果を挙げている顧客として、米Anthropic、日本のリコーとカラクリなどが紹介された。AWSのマネージドサービスであるAmazon Bedrockの本番環境でも稼働している。

|

|

|

|

具体的な提供価格は発表文には明記されていないが、導入企業では他社製品と比較してトレーニングや推論のコストを最大50%削減できたとされている。

|

|

|

|

|

|

|

|

Copyright(C) 2025 ITmedia Inc. All rights reserved. 記事・写真の無断転載を禁じます。

掲載情報の著作権は提供元企業に帰属します。